pLLama – wygenerowane za pomocą AI

Intro

Cześć Wam!

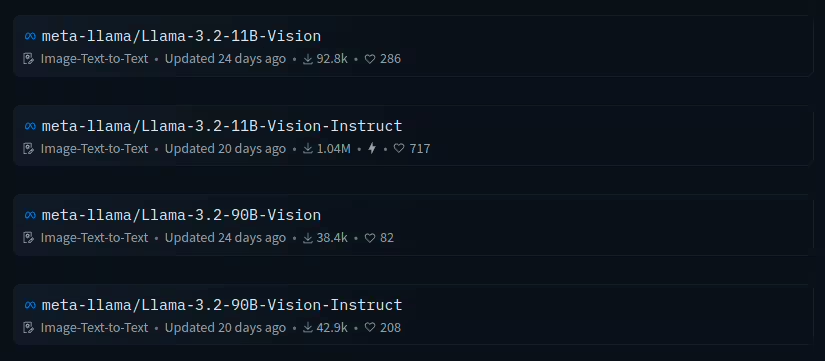

Dziś bardzo krótki wpis. Wpis o modelu, niewielkim jak na te czasy. Pewnie słyszeliście o LLamie3.2 od MetaAI? Meta udostępniła ostatnio modele do generowania treści (Instruct) ale i obrazów (Vision-Instruct).

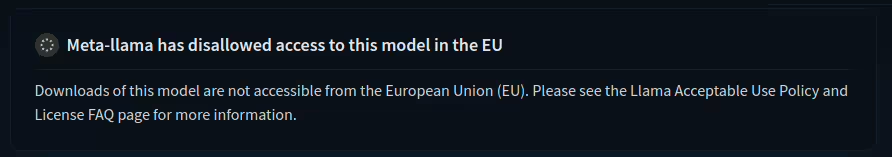

Niestety modele Vision-Instruct nie są dostępne w Unii Europejskiej no i przy okazji w naszym kraju.

Zatem…. co nam zostało? Zostało nam douczyć małe modele tekstowe w architekturze 1B oraz 3B na nasz język 😉

Dane i Trening

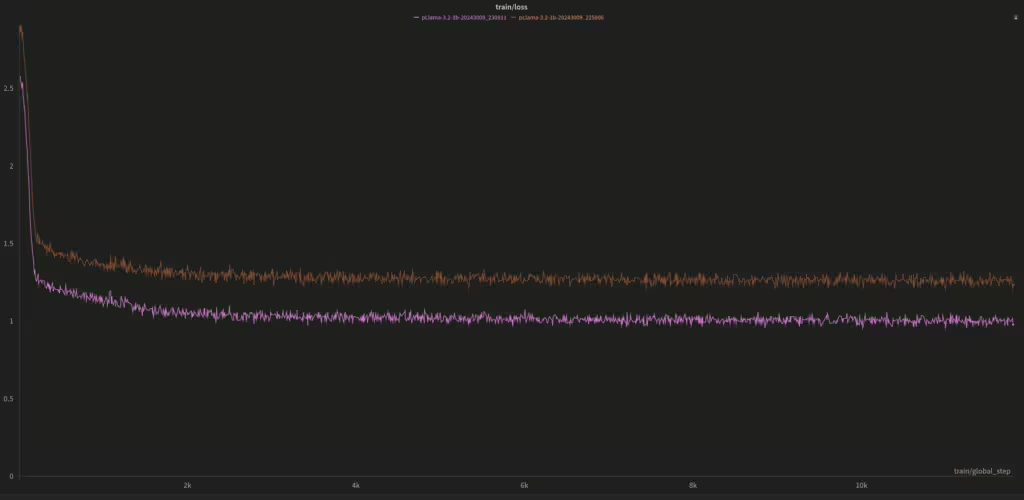

Do douczania zastosowaliśmy najpierw technikę fine-tuningu, a następnie w procesie DPO trenowaliśmy oba modele na korekcję języka. Dane dokładnie te same, co w przypadku pLLamy3 (Kliknij aby przeczytać artykuł) .Zarówno do fine-tuningu, jak i DPO. Jedynie mała zmiana w hiperparametrach uczenia (batch size, learning rate). Liczba epok w FT to 5, liczba kroków w DPO 50k. A… no i uczenie na 16 bitach 🙂

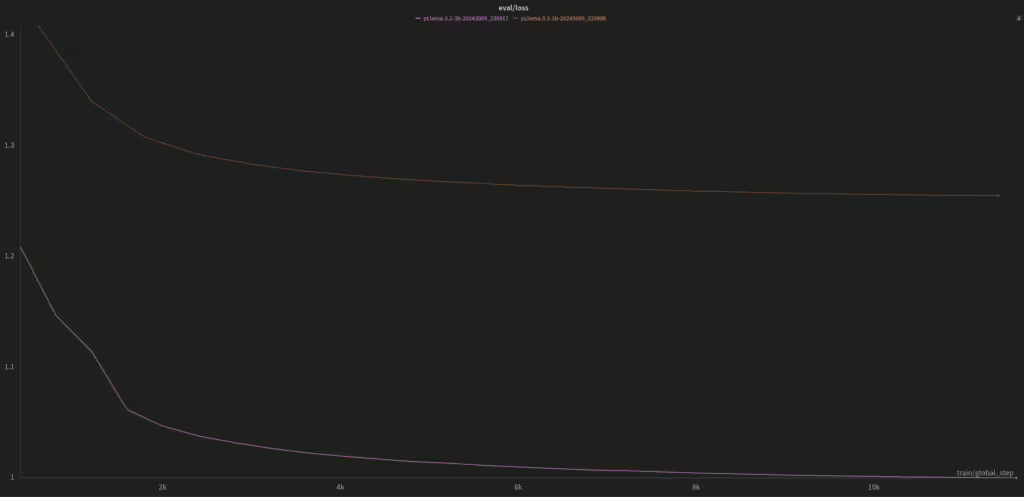

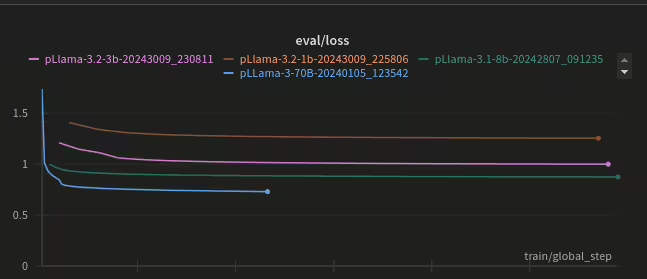

Zobaczcie sami na wykres funkcji straty zarówno na części treningowej i ewaluacyjnej (to sam proces fine-tuningu na język polski):

I dokładnie taka między nimi jest różnica 🙂

Odczucia

Jako, że modele 1B oraz 3B to destylacja modeli już istniejących zapewne oceniana w większości na danych anglojęzycznych, ciekawy był efekt całego procesu douczania tych modeli. Model w architekturze 1B (zarówno po FT ale i po DPO) to chyba najmniej sprawny model z całej naszej kolekcji — ale statystyki mety pokazują dokładnie to samo. Zaś model w architekturze 3B, to zupełnie inna liga niż 1B. Można powiedzieć, że działa zgodnie z oczekiwaniami 🙂

Porównywanie ich do większych modeli mija się trochę z celem, ponieważ w przypadku 1B i 3B Meta postawiła na możliwość uruchamiania ich na mniej wydajnym sprzęcie, a nawet na komórce 😉 O ile model 1B słabo sobie radzi, o tyle 3B potrafi zaskoczyć.

Modele do pobrania

Zapraszamy oczywiście na nasz HuggingFace, na którym stworzyliśmy kolekcję z modelami pLLama3.2 Models. Wszystkie modele oczywiście udostępniamy publicznie za darmo:

- Modele w architekturze 1B: radlab/pLLama3.2-1B – model tylko po fine-tuningu, oraz radlab/pLLama3.2-1B-DPO po FT + DPO

- Modele w architekturze 3B: radlab/pLLama3.2-3B model tylko po fine-tuning, oraz radlab/pLLama3.2-3B-DPO po FT + DPO

Częstujcie się 🙂

Co dalej?

Dalej będzie nie-ko-po-le-i: pLLama3.1-8B (to ten zielony wykres) oraz L31 jako pewien ciekawy mix…

Pingback: pLLama3.1 8B — czyli średnio-duże a nawet małe GenAI dla Polskiego – RadLab

Pingback: Etyka i bezpieczeństwo w GenAI – RadLab